SEO対策を自社サイトに取り入れるための重要な一歩、それが検索エンジンのクローリングへの理解と最適化です。

検索順位を上げるためにSEO対策が必要なことは分かっていても、クローリングについてはあまり理解できていないという人は多いのではないでしょうか。

この記事では、クローリングによって自社サイトが検索エンジンにどのように認識され、インデックス化されるかについて解説します。

クローリングについてよく理解し、自社サイトの検索順位を引き上げましょう。

検索エンジンのボット、クローラーとは

検索エンジンのクローラーとは、Webサイトを巡回して情報を収集するボットです。

クローラーの機能はコンテンツやリンクの収集、新しいページの特定、インデックスへの追加など多岐にわたります。

クローラーは、特定のページへのアクセスを制御するためにrobots.txtファイルを活用しています。

ただしクローラーは常に進化し、検索エンジンのアルゴリズムも定期的に更新されています。最適なSEO対策を行うためには、これらの動向を把握し続けることが必要です。

具体的には新しいページの追加やrobots.txtの設定など、クローラーが持つ限界を理解した上で最適な戦略を練ることが求められます。

クローラーにはどのような種類が存在するのか

クローラーは検索エンジンのロボットプログラムで、インターネット空間を巡回しながら情報を収集しています。

そのためクローラーについての理解が不十分だと、適切なSEO対策は行えません。

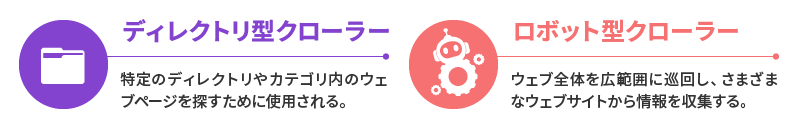

クローラーには主にディレクトリ型とロボット型があり、その活動はクローリング・パーシング、インデックス、クエリプロセスという3つの工程に分けられます。これらのクローラーは蜘蛛の巣のようにリンクをたどって情報を収集し、データベース化するため「スパイダー」とも呼ばれています。

これらのクローラーが集めた情報は、検索エンジンが検索順位を決定する上で大きなウェイトを占めています。

そのため、Webサイトがクローラーによって効率的に巡回・解析される「クローラービリティ」を高めることは、SEO対策の重要なポイントです。

クローラービリティを高めるためにはrobots.txtの設定、リンク構造の改善、コンテンツのマークアップ、ページ速度の改善などの対策が必要となります。

クローラーについてよく理解し、適切なSEO対策を進めることがWebサイトの視認性を高める重要なステップです。

それがクローラービリティを高め、最終的には検索エンジンでの順位を改善することにつながります。

収集しているファイルの種類

クローラーが収集しているファイルの種類は多種多様で、HTML、テキスト、CSS、画像、JavaScript、PDF、XML、JSON、TSV、FLASHなどが例として挙げられます。

これらを総合的に把握することで、クローラーはWebサイトの全情報を集約し、検索エンジンのデータベースに登録します。

このようなクローラーの働きにより、ユーザーは効率的に情報を検索することが可能になるのです。

一方でファイルサイズが大きいとクローラビリティに影響を及ぼし、リソースの無駄となります。

画像やCSS、JavaScriptなどのファイルの圧縮、不要なソースコードの削除など、クローラー側に寄り添った改善が求められます。

ファイルサイズの削減ができると、その分クローラビリティを向上させることが可能となります。

具体的にはクロール速度が早まり、余ったクロールのリソースを他のコンテンツに配分できるようになります。そうしてクローラーにとって情報収集による負荷が軽くなり、結果として自分のサイトに高いSEO評価をつけるよう促すことが可能です。

スクレイピングの違いとは

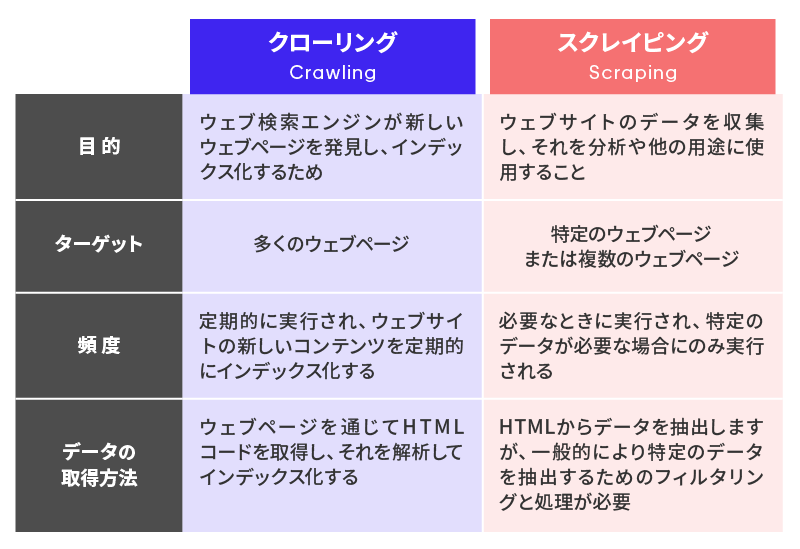

クローリングとスクレイピングは目的と手法が異なります。

クローリングでは自身で次にアクセスすべきURLを発見します。

その主な目的はWebサイトを巡回し、情報を収集・保存することです。

一方、スクレイピングでは特定のページにアクセスします。

これはあらかじめ抽出すべき情報が決まっているためで、その主な目的は特定の情報の抽出です。

しかし、スクレイピングはWebサイトの構造に強く依存しているため、その構造が変更されるとスクレイピングのための用意を大幅に変更する必要が発生することがあります。

さらに、むやみなスクレイピングの実行は過度なサーバ負荷などの問題の原因になるため、Webサイトの運営者が定める利用規約に違反する可能性もあります。そのため、スクレイピングを利用する際は注意が必要です。

似たような概念ですが、こうして詳細を比較すると異なる点の多さが分かります。適切に区別して理解しましょう。

クローリングについて目を向けることの重要性とは

クローリングに目を向ける必要がある理由は、クローリングがWebサイトから情報を収集するための重要な技術だからです。

クローリングの目的は、Webサイト内を巡回し情報を収集・保存することです。収集された情報は検索エンジンのデータベースに登録され、検索結果に表示されます。

クローラーは実行中に自身で次にアクセスすべきURLを発見し、Webサイトの情報を収集できる能力を持っています。

実際にどのようにクローリングされているのか

クローリングのプロセスは、基本的にクローラーによる情報収集から始まります。クローラーによって収集した情報が検索エンジンのインデックスに登録され、最後にアルゴリズムによって検索結果が生成されます。

このプロセスを理解することは、検索エンジンの最適化(SEO)にとって必要不可欠です。

具体的な最適化の方法としては、まず、関連ワードを含むコンテンツを作成することが重要であり、検索エンジンはこれらを高く評価する傾向にあります。

さらに、狙いたいキーワードをタイトルに含めるというキーワード選定も重要な要素です。

また、ユーザーの次のアクションを後押しするようなコンテンツを作成することで、記事の目的やターゲットを明確にすることが求められます。

そして、記事の差別化を図るためには、既存の記事を調査し、Googleの検索コマンド「site:」を利用することが有効です。

しかし、サイトの専門性を揺るがすような記事は避けましょう。一般的にそのような記事とは、今までそのWebサイトが一貫して提供してきた内容やテーマから大きく逸脱した記事が該当するとされています。専門性への評価に悪影響が及ぶことで、検索エンジンの評価にも悪影響を与えてしまう可能性があります。

| 例えば、医学や健康に関する情報を提供してきたWebサイトが、急にエンターテイメントやファッションに関する記事を大量に掲載し始めた場合、クローラーはそのWebサイトの専門性が揺らいだと判断します。 |

また、ユーザーは特定のトピックや情報についての専門的なWebサイトを探して訪れるため、内容が一貫していないとユーザーはそのサイトを信頼しなくなり、再訪率が下がる可能性があります。

これも間接的に検索エンジンの評価に悪影響を与えます。

クローリングされている様子を確認できる

Webサイトはクローリングによって、どのように検索エンジンに取り込まれているのでしょうか。

ここからは、クローリングの一連の流れについて詳しく解説します。

クローリングの働きについて理解し、自社サイトの改善につなげましょう。

Google Search Consoleから確認する

Webサイトの運営者にとって、自身のサイトがどのようにクローリングされているかを理解することは重要です。

その情報を得ることで、Webサイトの検索エンジン対策をより効果的に行うことができます。

ここでは、その過程を「Google Search Console」を用いて確認する方法を紹介します。

Google Search Consoleは、Googleが提供する無料のツールで、自社サイトがGoogle検索でどのように表示されるかを管理するためのものです。

Webクローラーがサイトをどのようにクロールし、インデックス作成を行っているか詳しく見ることができます。

まず、Google Search Consoleにログインします。

左側のメニューから「クロール」を選び、「クロールエラー」をクリックすると、Googlebotが自社サイトをクロールする際に遭遇した問題が表示されます。

また「URL検査」ツールを使うと、特定のページがどのようにGoogleに認識され、インデックスされているかを確認することが可能です。

ページのURLを入力して「検査」をクリックすると、そのページに関する詳細な情報が表示されます。

これらの情報を用いることでクローリングによる評価結果を確認すると同時に、Webサイトの問題点を特定し、改善することが可能となります。

Google Search Consoleを活用して、Webサイトのクローリングとインデックス化の状況を把握し、最適なSEO対策を行いましょう。

クローリングの状況を確認することで、Webサイトのパフォーマンス向上につながるため、定期的に自社サイトがどのように検索エンジンに認識されているか確認してください。

1日にクロールが行われるページの総数

Google Search Consoleを活用することで、Googleのクローラーが1日に何ページクロールしているのかを把握することが可能です。

これはサイトの健全性を評価し、SEO戦略を計画する上で重要な情報となります。

確認方法はGoogle Search Consoleにログインした後、左側のメニューから「クロール」を選択し、次に「クロール統計」をクリックします。

ここに表示されるグラフは、過去90日間にGooglebotが自社サイトをクロールした総ページ数です。

特に「高度なフィルタ」を利用すると、特定の期間や特定のGooglebot(デスクトップやモバイル)によるクロール状況を細かく見ることができます。

このデータを見ることで、Googleが自社サイトをどの程度重視しているのか、新しいコンテンツがどれくらいの速度でクロールされているのかを確認することが可能です。

1日にクローラーによってダウンロードされるデータの総量

Google Search Consoleは、Googleのクローラーが自社サイトから1日にどの程度のデータをダウンロードしているかを把握するための強力なツールです。

これはサイトのパフォーマンスやインデックスの状態を理解するための重要な情報源となります。

まずGoogle Search Consoleにログインし、左側のメニューから「クロール」を選択します。

次に「クロール統計」をクリックすると、画面上部にグラフが表示されますが、これはGooglebotが自社サイトからダウンロードしたデータの総量を示すものです。

このデータ量からはGoogleが自社サイトをどれくらい頻繁にクロールしているか、自社サイトがどれほどの情報量を提供しているのかが分かります。

この情報を利用して、Webサイトがクローラーにどれだけの負荷をかけているのか、また新たなコンテンツがどれだけ早く検索結果に反映されているのかなどのチェックが可能です。

クローラーによってページをダウンロードするのにかかった時間

Webサイトにとってクローラーがページをダウンロードするのにかかる時間は、ページのパフォーマンスとSEOに直接影響を与える重要な要素です。

Google Search Consoleを使用することで、このダウンロード時間を確認することができます。

Google Search Consoleにログインし、左側のメニューから「クロール」を選択してください。

次に「クロール統計」をクリックし、表示されるグラフの中から「ダウンロード時間」を選択します。

表示されるグラフはGooglebotが自社サイトのページをダウンロードするのにかかった平均時間を示すもので、自社サイトの応答性とパフォーマンスを評価するための貴重な指標です。

もしダウンロード時間が長ければ、クローラーが自社サイトを完全にクロールするのに時間がかかり、新しいコンテンツや更新されたコンテンツがGoogleの検索結果に表示されるまで、時間がかかってしまうかもしれません。

この指標を定期的に確認し、必要に応じてWebサイトのパフォーマンスを最適化することで、SEOの効果を上げることができます。

生ログに目を通す

Webサイトのクローリング状況を把握するために、Google Search Consoleだけでなくサーバーの生ログに目を通すことも重要です。

サーバーの生ログとは無加工のアクセスログを指したもので、ここからクローラーがどのページを訪れ、何を行ったのかを詳細に知ることもできます。

生ログの確認はWebサーバーの管理画面から行うことが可能です。

生ログを有効に利用するためには、クローラー名やステータスコードを確認してください。

クローラー名を検索すれば、そのクローラーがどのように動いているかを追うことが可能です。

また、ステータスコードを確認することで、クローラーがページを正常に取得できたのか、それとも何か問題が生じているのかを把握できます。

ただし、生ログの確認にはいくつか注意点があります。

生ログは大量の情報を含んでいるため、必要な情報を見つけるためには時間がかかるところです。

また生ログは個人情報を含むことがあるため、適切な管理が必要です。

生ログは容量が大きく、保存期間に制限がある場合があるため、必要な情報を適宜保存しておくようにしましょう。

クローリングを促すにはどうすれば良いのか

Webサイトのクローリングを促すためには、サイトのSEO(検索エンジン最適化)を強化し、サイトマップを作成することが重要です。

これにより、検索エンジンが情報を効率的にインデックス化できます。

ここからは、クローリングを促すための具体的な方法について解説します。

Google Search Consoleからクローリングの巡回自体を催促する

Google Search Consoleを使用することで、WebサイトがGoogleクローラーにより効率的に巡回され、インデックス化を催促することができます。

まずGoogle Search Consoleにログインし、自社サイトを選択します。

次に左側のメニューから「URL検査」をクリックしてください。

その後、検索窓に対象のURLを入力し、検査ボタンを押します。

検査が完了するとインデックス登録のリクエストが可能になる画面が表示されます。

Googleクローラーへの巡回申請は「インデックス登録をリクエスト」のオプションからも行えます。

ただし、巡回の申請を行ってもその結果がすぐに反映されるわけではありません。Googleクローラーの巡回は、自然な流れに従って行われるためです。

クローラーの巡回は、Webサイト内のリンク構造に基づいてページからページへと移動する形で行われます。Googlebotはあるページを訪れた後、そのページ上に存在するリンクをたどって次々と新しいページへと進んでいきます。

リンクの存在はクローラーに対し「このページから次のページへと進むべきだ」と指示する役割を果たすのです。

しかし、巡回の申請を行うことでそのプロセスを早めることができます。

Google Search Consoleを使用してGoogleクローラーに巡回を申請することは、Webサイトのインデックス化を促進する上で非常に効果的な手段ですが、その結果はすぐに現れるものではありません。

時間とともに効果を発揮するということを理解しておくことが重要です。

sitemap.xml Editorを活用する

サイトマップはWebサイトの構造を検索エンジンに伝える重要なツールです。「sitemap.xml Editor」はこのサイトマップの作成を簡単にする無料の自動生成ツールです。

sitemap.xml Editorはユーザー登録やダウンロードなしで利用可能で、最大1,000URL分のページ情報を1つのサイトマップに記載できます。

sitemap.xml Editorを使ってXMLサイトマップを自動生成するためには、まずsitemap.xml Editorにアクセスします。

次にWebサイトのURLを入力し、サイトの更新頻度や優先度の自動設定を選択してください。

最後に「サイトマップ作成」ボタンをクリックすると、XMLサイトマップが生成されます。

生成したsitemap.xmlファイルを本番環境にアップロードし、アップロード先のURLをGoogle Search Consoleから送信することで、Googleクローラーに巡回を促すことが可能です。

ただし、sitemap.xml Editorはページ数が1,000ページ以内という制限があるため、大規模なWebサイトには向かないことを覚えておきましょう。

1,000ページという範囲内であれば、XMLサイトマップを利用することでクローラーが効率よくサイトを巡回し、新しいページもインデックス化しやすくなります。

よくある質問と回答

Q.クローリングを最適化する方法は?

A.メタタグの設定、サイトマップの提供、速いページロード速度、適切なURL構造などを通じて最適化できます。

Q.クローリングとスクレイピングの違いはなんですか?

A.クローリングはウェブページを自動で訪れることで情報を収集するプロセスであり、スクレイピングは特定のウェブページから特定のデータを抽出する技術やプロセスを指します。

多くのウェブサイトは利用規約やrobots.txtによってスクレイピングを禁止または制限しています。

例えば、以下のようなウェブサイトはスクレイピングを禁止または制限しています。

- ソーシャルメディアプラットフォーム(Facebook、Twitter、LinkedInなど)

- オンラインショッピングサイト(Amazon、eBayなど)

- ニュースメディア

- 金融機関や銀行のウェブサイト

まとめ

この記事ではクローリングとは何か、その重要性と自社サイトへの適用方法について解説しました。

クローリングは検索エンジンがWebページを見つけ、その情報をインデックス化するための重要な過程です。

クローリングを理解し、最適化することはSEO対策にとって必要不可欠です。

自社サイトが検索エンジンにどのように認識され、インデックス化されるかを理解することで、検索順位を飛躍的に向上させることが可能となります。

クローリングへの知識を深めた上でツール等を使い対策を実践して、自社サイトの集客力を高めましょう。